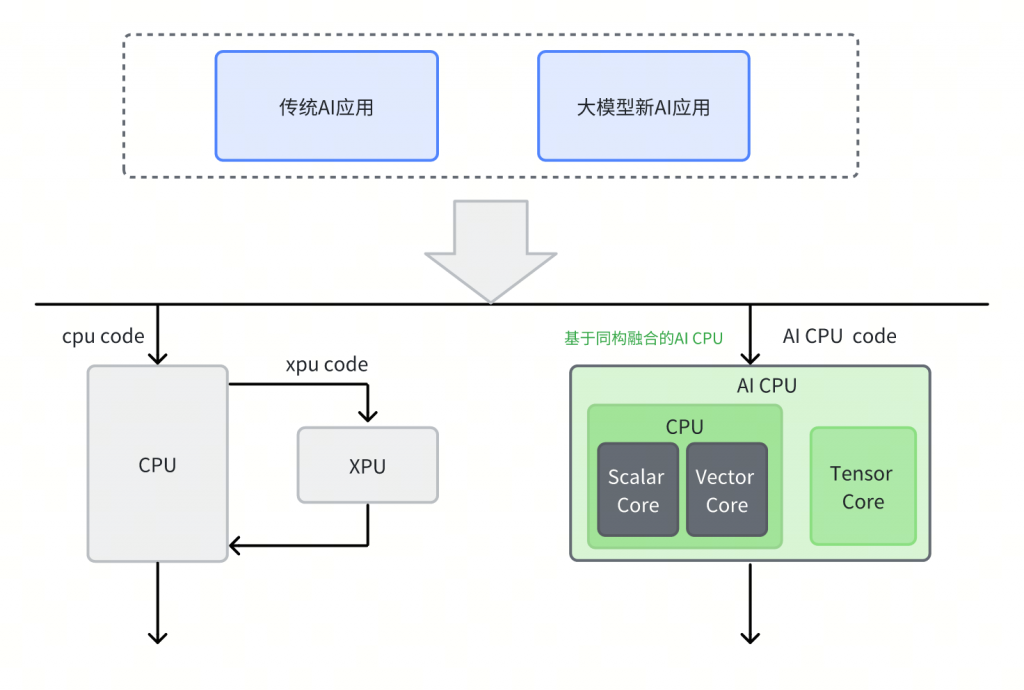

为了加速AI计算,芯片企业设计了多种专用处理器架构,如 GPGPU、NPU、TPU 等。这些专用处理器架构在执行调度代码及应用层代码时,需要主控CPU的配合,如下图所示。因此,通常需要构建复杂的异构调度系统来协调CPU和XPU的额外数据交互和同步。

进迭时空践行的同构融合技术,创新性地在 CPU 内集成 TensorCore,以 RISC-V 指令集为统一的软硬件接口,驱动 Scalar 标量算力、Vector 向量算力和 Matrix AI 算力,支持软件和 AI 模型同时在 RISC-V AI 核上运行,并通过程序正常跳转实现软件和 AI 模型之间的事件和数据交互,进而完成整个 AI 应用执行。我们将这种使用同构融合技术,得到具有 AI 算力的 CPU 称为 AI CPU。

虽然市面上已有多种不同架构且硬件做的非常出色的AI加速器,但是除了 AIOT 细分场景之外,Nvidia 占据了AI计算绝大多数市场份额,成为AI计算主流架构,并深刻影响工业界学术界AI计算的发展。Nvidia 通过 CUDA 将异构开发的门槛降至最低,并基于多层级的软件栈构建了护城河。基于这些软件栈,全球开发者都在壮大 Nvidia 生态。很多企业的 GPGPU 发展策略是硬件上学习 Nvidia,软件上兼容 CUDA 生态。由于很难跟上Nvidia的快速迭代,这条路径并不容易实现。

同构融合有望成为新的发展路径。相比于异构加速器和 CPU 的组合,同构融合技术在硬件层面上对 AI

算力和通用 CPU 进行了更高层次的封装,用户不需要关心主控 CPU 和异构加速器之间的数据同步,并且保留了通用 CPU 的调试和开发方式。厂商不需要开发复杂的异构调度系统,也不需要开发额外的驱动管理就可以让开发者便捷的使用AI算力。另外,同构融合技术中 CPU 的通用性和 RISC-V 架构良好的开源生态基础,进一步降低了需要自建软件栈的复杂度。

综上,进迭时空基于开源软件生态,以更轻的基础软件设施,构建了接近 Nvidia 的软件层级,如下图所示。我们的目标是,基于这些软件层级,达到接近 Nvidia 的 AI 通用性。

进迭时空基于同构融合技术完成两代通用RISC-V AI核的研发。

第一代 RISC-V AI 核 A60 实现 2Tops 算力,支持 INT8 等数据格式。A60 核已经应用于RISC-V AI CPU芯片K1,实践表明,同构融合AI算力可以无缝运行所有AI算法,更安全地加速从 TEE 到 REE 所有 AI 应用。RISC-V AI CPU 芯片 K1 也是第一个完整提供 Scalar、Vector 和 Matrix 三个维度关键算力的 RISC-V 芯片。在运行常见的AI算法时,K1 的实际性能是传统芯片的3-5倍,某些AI应用帧率提升可达10倍以上。

尤其是在运行大模型算法时,Matrix 算力可以从容应对 prefill 阶段的算力需求,CPU 出色的访存系统可以解决 decode 阶段的带宽需求,无需构建复杂的异构计算调度系统。此外,由于 CPU 的通用性,可以支持几乎所有低 bit 量化方式,将带宽需求降至最低。

更重要的是,将整个 AI 应用涉及的计算步骤全部迁移至 AI CPU 上,还可以为客户提供更加简单高效的开发方式。不仅能够避免在多个硬件设备上开发和调试,而且在一个编程模型覆盖AI开发全过程,能够让部署和调试变得轻松,让算法快速实现价值。例如,K1 芯片在客户场景下,可以把在传统 NPU 上适配新算法所需的3-6个月时间压缩到1周以内,K1芯片已支持多个客户在语音和机器视觉领域快速开发了基于最新AI 大模型的产品。

第二代RISC-V AI核A100已经研发完毕,预期无论在大模型运行效率方面,还是运行传统AI效率方面都能达到业界先进水平。

此外在算力堆叠方面,同构融合技术路线通过采用 Core-to-Core coherence 和 Cluster-to-Cluster coherence,能以与 GPU 相同的技术实现多芯片级联和算力堆叠。与总线的 Die2Die 一致性技术结合后,通往多芯片算力堆叠的规模有望接近现有最先进 GPU 集群。

MOE模型(Mixture of Experts,混合专家模型)是一种基于分而治之策略的神经网络架构,它将复杂的问题分解为多个子问题,每个子问题由一个独立的模型(称为专家)进行处理。MOE 模型在单请求推理场景,每个 token 只需要使用部分专家参与计算。这些专家共同组成了 MOE 模型的激活参数。以 DeepSeek-R1 模型为例,671B 的模型,只有37B的激活参数。对于 FP8 的模型,相当于需要将近 700GB 的容量来存放模型所有的权重,但是在进行单请求推理时,每个token只需要使用将近 40GB 的权重。相比于Dense模型,MOE模型是一个大容量,弱带宽的推理需求。相较于 GDDR 和 HBM,内存容量更容易扩展;再加上专家的选择是动态的,其计算和访存模式是CPU极其擅长的。

GPU 与 NPU 适合密集的重复计算模式,而CPU适合复杂调度场景下的计算模式,AI CPU 介于两者之间。MoE 的兴起,代表了一个兼具大容量与复杂逻辑的大模型发展趋势,而这正是 AI CPU 的发力场景。